Terakhir diperbarui pada Oktober 16, 2022

Peta situs (sitemap) merupakan salah satu alat untuk mempermudah mesin pencari (misal, Google, Bing, Yandex) dalam mengindeks halaman web. Umumnya, mesin pencari mengenali beberapa format umum peta situs, seperti XML, RSS, Atom, atau TXT [1]. Biasanya, kamu harus terlebih dahulu mendaftarkan peta situs kamu melalui Webmaster Tool (misal, Google Search Console), sebelum mesin pencari dapat mulai mengindeks halaman web.

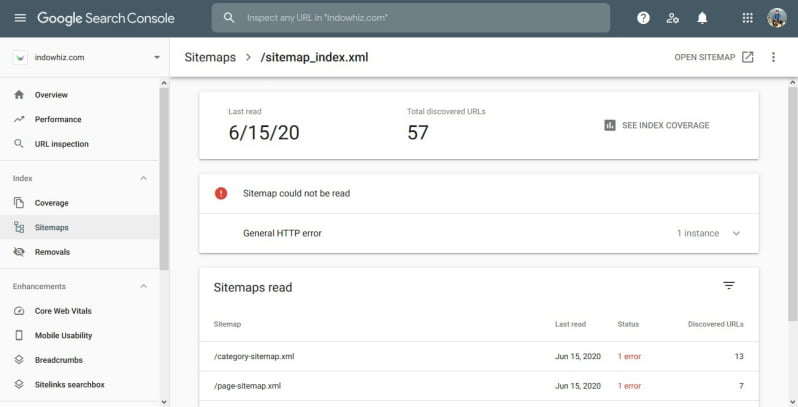

Namun, mendaftarkan peta situs tidak 100% bebas dari kesalahan. Administrator situs dapat mengalami hal-hal yang tidak terduga. Misalnya, peta situs tidak dapat diakses atau dibaca oleh mesin pencari. Banyak faktor yang menyebabkan masalah ini, termasuk masalah peta situs maupun karena kesalahan 403 (akses ditolak).

Catatan: kesalahan 403 (akses ditolak), berarti mesin pencari tidak diizinkan untuk mengakses peta situs.

1. Memeriksa akses ke peta situs

Ada beberapa cara untuk memeriksa apakah bot mesin pencari dapat mengakses peta situs kamu. Kamu dapat mencoba menggunakan situs web yang menawarkan layanan pemeriksaan bot atau menggunakan chrome dengan mengubah “user agent“-nya. Umumnya, pemeriksaan ini khusus untuk peta situs dalam format XML. Namun tidak ada salahnya untuk mencoba jika ingin mengecek format sitemap selain XML.

A. Menggunakan situs online

Ada banyak situs online yang menyediakan layanan untuk memeriksa akses sitemap, seperti:

- XML-Sitemaps.com (ubah pilihan

User AgentmenjadiGoogle) - Google Robots.txt Tester

- Google URL Inspection Tool

B. Menggunakan peramban Chrome

Sebagai alternatif, kita dapat menggunakan peramban (browser) Chrome untuk memeriksa akses ke peta situs. Untuk tujuan ini, kamu perlu mengubah user agent menjadi Googlebot, yang merupakan perayap (crawler) utama Google [2].

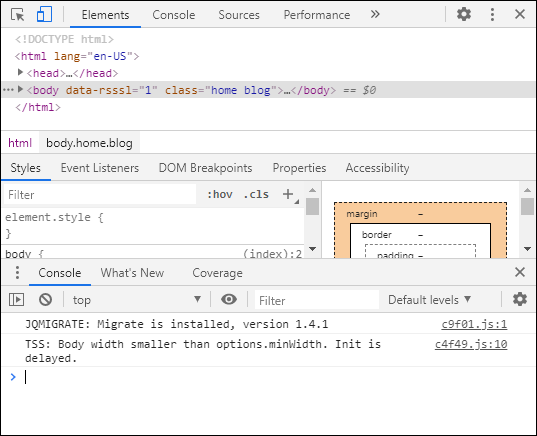

Pertama, buka developer tools terlebih dahulu, caranya yaitu:

- pada peramban Chrome, klik menu atau tombol

⋮di pojok kanan atas, - pilih

More tools>Developer tools.

Maka kamu akan melihat tampilan seperti pada Gambar 2 di Chrome.

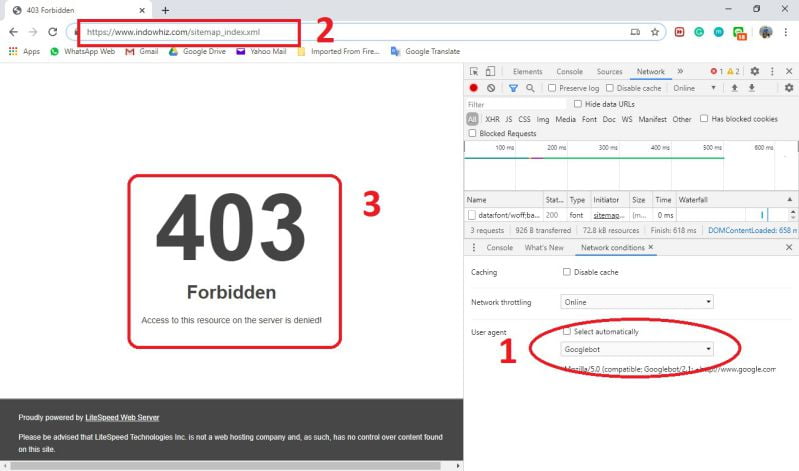

Kedua, ubah user agent pada Chrome. Caranya yaitu:

- klik tombol

⋮di pojok kiri bawah (di menu bawah dekat tabConsole), - klik

Network conditions, - pada kotak

user agent, hilangkan centang padaSelect automatically, - lalu pilih

Googlebotpada opsi dropdown.

Setelah mengubah user agent, periksa apakah kamu dapat mengakses peta situs menggunakan Chrome seperti pada Gambar 3.

C. Menunggu pembacaan berikutnya

Kamu mungkin telah mencoba subbab 1-A dan 1-B di atas, dan tidak ada masalah dalam mengakses peta situs. Jika demikian, harap tunggu mesin pencari membaca peta situs kamu dalam beberapa hari ke depan.

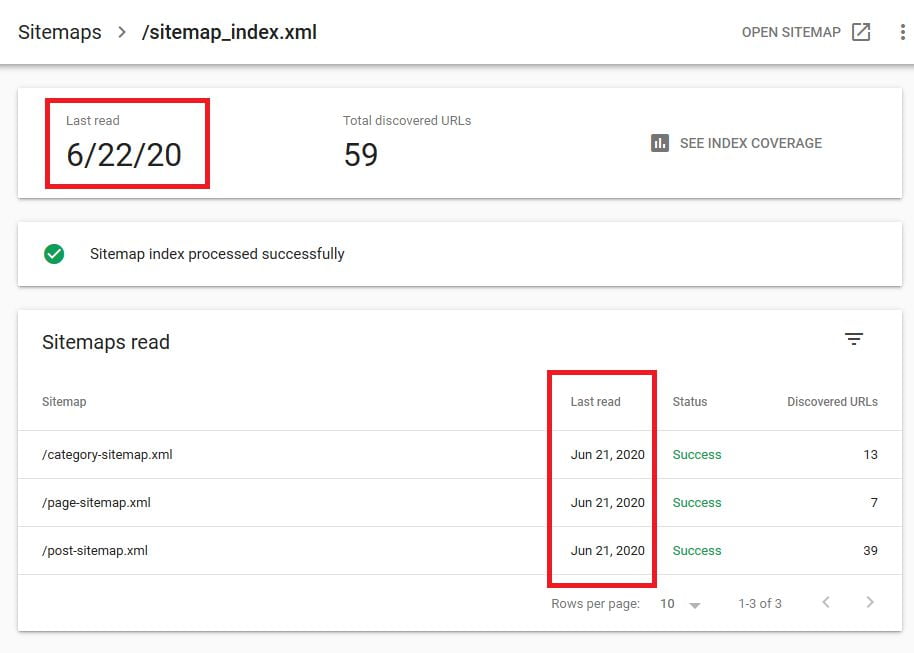

Misalnya, mengirim ulang peta situs ke Google Search Console mungkin menunjukkan kesalahan “Tidak dapat mengambil peta situs“. Padahal, tidak ada masalah dengan akses ke peta situs, seperti pada subbab 1-A dan 1-B di atas. Dalam hal ini, tunggu tanggal “terakhir dibaca” berikutnya, karena Google membaca peta situs beberapa hari sekali. Biasanya, tidak ada masalah lain lagi.

terakhir dibaca” berikutnya.2. Mengatasi akses pada peta situs

Jika mesin pencari tidak dapat mengakses atau membaca peta situs (misal, kesalahan 404 atau 403), beberapa metode patut dicoba.

Sebelum mencoba menyelesaikan masalah, lakukan “backup” pada keseluruhan situs webmu!

A. Pastikan alamat peta situs sudah benar

Sebelum mencoba berbagai hal teknis, coba buka URL peta situsmu langsung di peramban. Jika kamu mendapatkan kesalahan dengan kode 404, ada beberapa kemungkinan, antara lain:

- Salah memasukkan URL peta situs; cobalah untuk memeriksa kembali URL peta situs kamu.

- Situs gagal membuat peta situs; Jika kamu menggunakan CMS (misal WordPress) beserta plugin pembuat peta situs, mungkin ada masalah dengan pengaturan plugin pembuat peta situs.

Catatan: jika kamu menggunakan chrome dan mengubah user agent seperti pada Subbab 1-B di atas, maka terlebih dahulu ubah kembali user agent dengan memberikan centang pada Select automatically.

B. Gunakan hanya satu generator peta situs

Dalam kasus CMS WordPress, banyak orang mungkin menginstal plugin SEO (misal Yoast atau RankMath) dan generator peta situs (misal Google XML Sitemaps). Karena keduanya dapat membuat peta situs secara independen, dan kemungkinan akan saling mengganggu.

Oleh karena itu, pastikan hanya satu plugin yang boleh membuat peta situs. Setelah itu, periksa kembali akses ke peta situs menggunakan situs pemeriksa atau Chrome, seperti pada Bab 1.

C. Periksa file robot.txt dan .htaccess

File robot.txt atau .htaccess dapat memblokir perayap (misal Googlebot) dalam membaca peta situs [3]. Berikut contoh pengaturan robot.txt yang memblokir Googlebot:[4]

User-agent: Googlebot

Disallow: /Kode di atas berarti bahwa Googlebot tidak dapat mengakses seluruh situs. Jika kamu ingin mengizinkan Googlebot mengakses situsmu, hapus kedua baris kode di atas.

Selain itu, periksa file .htaccess apakah ada kode seperti berikut:

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} Googlebot [OR]

RewriteCond %{HTTP_USER_AGENT} msnbot [OR]

RewriteCond %{HTTP_USER_AGENT} yandexbot

RewriteRule ^.*$ "https\:\/\/www\.indowhiz\.com" [R=301,L]Jika ada, coba hapus sementara. Kemudian, periksa kembali akses ke peta situs menggunakan situs pemeriksa atau Chrome, seperti pada Bab 1.

D. Periksa pengaturan CDN

Banyak situs terkenal, seperti Google Cloud CDN, AWS, Cloudflare, dan QUIC.cloud, menawarkan layanan Content Delivery Network (CDN). Terkadang beberapa masalah terjadi karena cache, firewall, atau pengaturan pada CDN.

Untuk memeriksa apakah CDN menjadi penyebab masalah, coba nonaktifkan CDN. Kemudian, periksa kembali akses ke peta situs menggunakan situs pemeriksa atau Chrome, seperti pada Bab 1. Ada dua kemungkinan setelah menonaktifkan CDN, yaitu:

- Peta situs dapat diakses. Ini berarti bahwa pengaturan CDN menyebabkan masalah, yang memblokir akses ke peta situs. Coba verifikasi dan sesuaikan cache, firewall, dan pengaturan lain yang mungkin menyebabkan masalah tersebut. Jika kamu kesulitan mengaturnya, coba minta bantuan dari penyedia CDN.

- Peta situs belum dapat diakses. Artinya, masih belum dapat dipastikan bahwa pengaturan CDN tidak bermasalah. Ada kemungkinan bahwa bukan hanya CDN yang menyebabkan masalah ini. Dalam hal ini, kami sarankan untuk tetap menonaktifkan CDN sampai kamu dapat menyelesaikan masalah akses menggunakan metode lain.

E. Periksa plugin keamanan CMS

Penggunaan CMS (misal WordPress), biasanya bersama dengan plugin keamanan (misal Wordfence, Sucuri, atau iThemes). Plugin keamanan sangat membantu, tetapi terkadang juga sangat menyebalkan.

Untuk memeriksa apakah plugin keamanan CMS menjadi penyebab masalah, coba nonaktifkan terlebih dahulu. Kemudian, periksa kembali akses ke peta situs menggunakan situs pemeriksa atau Chrome, seperti pada Bab 1. Ada dua kemungkinan setelah menonaktifkan plugin keamanan CMS, yaitu:

- Peta situs dapat diakses. Artinya, plugin keamanan CMS menjadi penyebab masalah, yang memblokir akses ke peta situs. Coba verifikasi dan sesuaikan pengaturan plugin keamanan. Jika kamu kesulitan menyesuaikannya, coba minta bantuan dari pengembang plugin.

- Peta situs belum dapat diakses. Artinya, masih belum dapat dipastikan bahwa plugin keamanan CMS tidak bermasalah. Ada kemungkinan bahwa tidak hanya plugin keamanan CMS yang menyebabkan masalah ini. Dalam hal ini, kami sarankan untuk tetap menonaktifkan plugin keamanan CMS sampai kamu dapat menyelesaikan masalah akses menggunakan metode lain.

F. Periksa pengaturan WAF

Penggunaan panel kontrol web (mis., CPanel, Plesk, atau WHM), biasanya bersama dengan Web Application Firewall (WAF) (misal ModSecurity atau Imunify360). Ada kalanya, WAF seperti ModSecurity memblokir akses bot (bahkan Googlebot) karena dianggap spam atau bot berbahaya.

Untuk memeriksa apakah pengaturan WAF menjadi penyebab masalah atau tidak, coba nonaktifkan terlebih dahulu. Kemudian, periksa kembali akses ke peta situs menggunakan situs pemeriksa atau Chrome, seperti pada Bab 1.

Jika peta situs dapat diakses setelah menonaktifkan WAF, artinya pengaturan WAF menjadi penyebab masalah ini. Coba verifikasi dan sesuaikan pengaturan WAF yang mungkin menjadi penyebab masalah. Jika kamu kesulitan mengaturnya, coba minta bantuan dari penyedia hosting.

G. Meminta bantuan

Mungkin kamu sudah mencoba semua cara di atas tetapi tidak ada yang berhasil. Jadi, kamu mungkin memerlukan bantuan dari penyedia hosting untuk mengatasi masalah tersebut. Alternatifnya, kamu juga dapat meminta seorang profesional untuk memecahkan masalahmu.

Referensi

- [1]Google, “Mengelola peta situs Anda: Laporan peta situs,” Bantuan Search Console. https://support.google.com/webmasters/answer/7451001?hl=id (accessed Jun. 19, 2020).

- [2]Google, “Ringkasan crawler Google (agen-pengguna),” Bantuan Search Console. https://support.google.com/webmasters/answer/1061943?hl=id (accessed Jun. 19, 2020).

- [3]A. Gent, “How to Check XML Sitemaps are Valid,” DeepCrawl, Apr. 10, 2019. https://www.deepcrawl.com/knowledge/guides/check-xml-sitemaps-are-valid/ (accessed Jun. 19, 2020).

- [4]Remiz, “Block Google and bots using htaccess and robots.txt,” HTML Remix, May 03, 2011. https://www.htmlremix.com/seo/block-google-and-bots-using-htaccess-and-robots-txt (accessed Jun. 19, 2020).

Cara 1.A barusan saya coba blm work ini mas , saya pakai blogger robots txt juga sudah benar

kalau blogger, URL peta situs umumnya seperti ini:

example.blogspot.com/atom.xml?redirect=false&start-index=1&max-results=1000

atau jika sudah pakai domain:

example.com/atom.xml?redirect=false&start-index=1&max-results=1000

lanjutan pertanyaan saya yg tadi mas…

Peta situs dapat dibaca, namun mengalami error

Tidak ada tag XML

1 instance

Tag yang diperlukan hilang. Silakan menambahkannya dan mengirimkannya kembali.

Contoh

Baris 3

Tag induk:

urlset

Tag:

url

kalau mau, XML peta situs Mas Wahyu bisa dibandingkan dengan contoh ini:

https://developers.google.com/search/docs/advanced/sitemaps/build-sitemap?visit_id=637922904473009300-607881958&rd=1

nah klo ada yang tidak sesuai, bisa diperbaiki lalu dikirim ulang.

_____________________

Anyway, Mas Wahyu pakai wordpress dan yoast kah?

Kalau iya, kan biasanya kita mengirim peta situs yang ini:

/sitemap_index.xml

Nah, coba diganti dengan sub peta situs, seperti ini:

/page-sitemap.xml

/post-sitemap.xml

/peta-situs-lainnya-kalau-ada.xml

….

betul mas…itu sitemap saya juga seperti itu…saya pakai plugin yoast

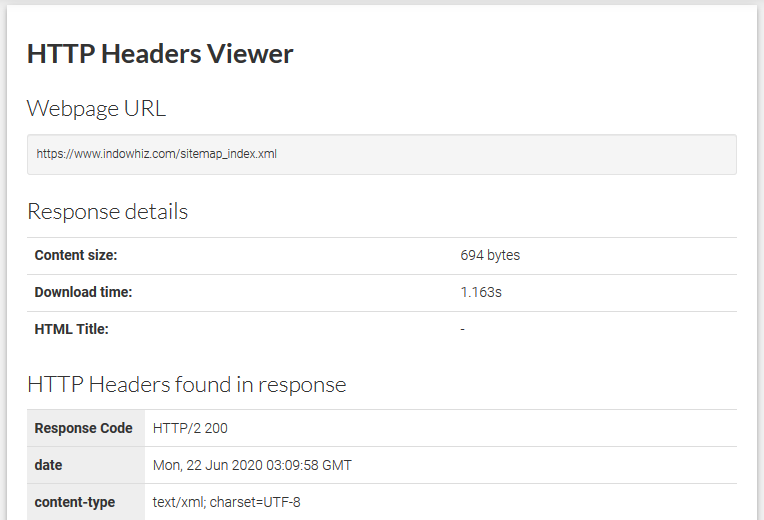

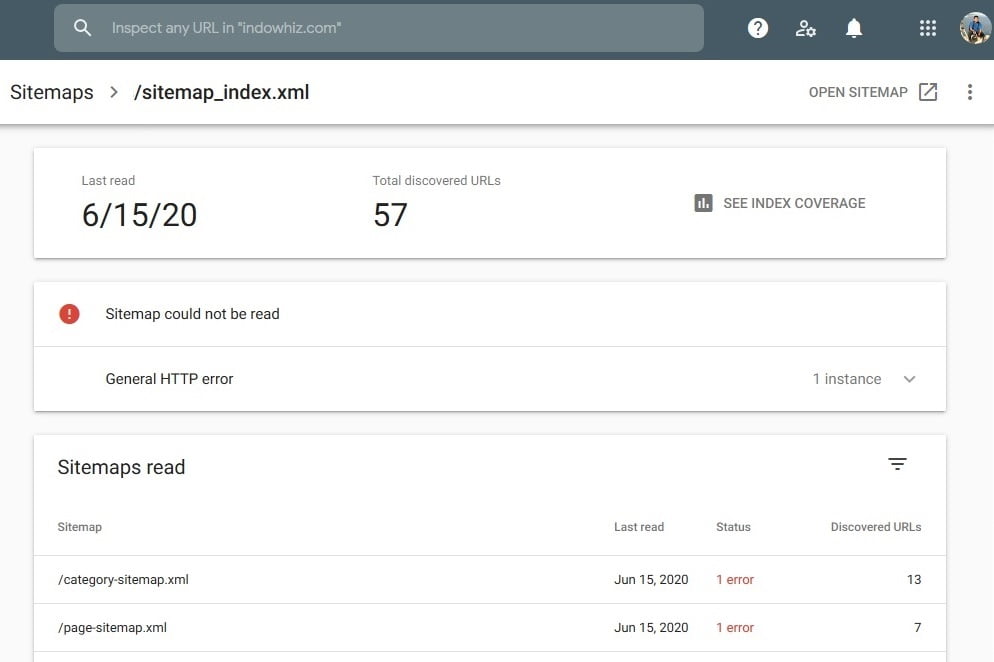

mas…kode respon saya sudah 200 (yg artinya tidak ada masala). tapi kenapa ya masih couldnt fetch dan Tidak dapat membaca peta situs

Kesalahan HTTP umum.

ada solusi?

akhirnya masalah ku teratasi, terimakasih artikelnya. sangat membantu

Alhamdulillah

Hello mas Philip terima kasih atas informasinya. Kebetulan banget saya punya masalah yang sama dengan artikel yang ditulis. Casenya:

Sitemap situs bisa dibuka ) ini sukses dilakukan. Tetapi pas saya mau verifikasi sitemap ini di Google search console tertulis couldn’t fetch.

Kemudian saya coba indeks atau crawling yang muncul malah error 403.

Sempat membaca di komunitas google search console, katanya harus menonaktifkan modsecurity di cpanel. Tetapi saya ragu + takut karena situs yang saya kelola situs perusahaan. Tolong sarannya mas agar situs saya bisa di crawling oleh Google.

Terimakasih.

Modsecurity bisa dinonaktifkan sementara selama beberapa menit hanya untuk memeriksa apakah security ini yang memblokir googlebot. Setelah itu bisa diaktifkan kembali.

Untuk selanjutnya, setelah mendapatkan hasil modsecurity di atas, keputusan bisa didiskusikan dengan perusahaan.

Url sitemap bisa dibuka dengan semua browser, tetapi pas submit di search console tidak bisa min. Ada peringatan “Tidak dapat membaca peta situs

Kesalahan HTTP umum”

Jika baru saja disubmit,

perlu tunggu beberapa hari sampai tanggal “last read” atau tanggal “terakhir dibaca” berikutnya,

seperti pada bagian 1C di atas.

Lanjutkan nulis 🙂